1. 简介

批量插入是指将多条记录通过一次操作插入数据库的过程。这种技术在需要导入大量数据的场景中特别有用,例如批处理、数据迁移或在应用程序设置期间填充数据库。

1.1 为什么要使用批量插入?

批量插入对于优化性能至关重要,因为它减少了与多次单独插入操作相关的开销。与逐条插入记录相比,批量插入将大量记录通过一次查询发送到数据库,从而减少了数据库的往返次数。

1.2 常见用例

- 数据迁移:在将数据从一个系统迁移到另一个系统时,批量插入可以加速该过程。

- 批处理:在处理大量数据的应用程序中,批量插入用于高效地存储处理后的数据。

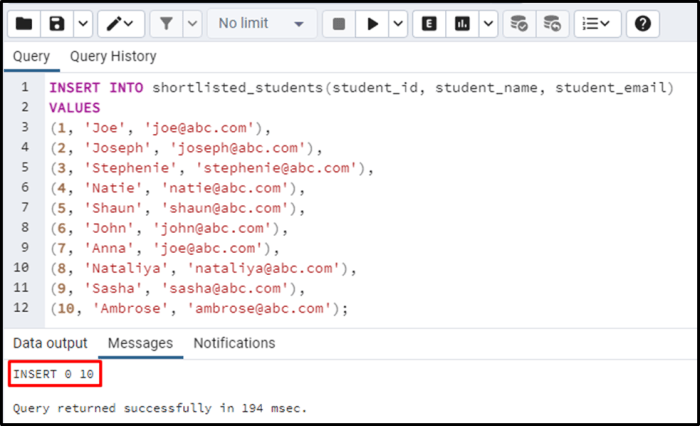

- 初始数据加载:在设置数据库时,批量插入通常用于用初始数据填充表。

2. 在 Spring Boot 中实现批量插入

Spring Boot 提供了多种执行批量插入操作的方式。方法的选择取决于应用程序的具体需求和约束,例如数据集的大小、使用的数据库以及对事务管理的需求。

2.1 使用 Spring Data JPA

Spring Data JPA 是 Spring Boot 中处理数据库操作的热门选择。尽管 JPA 本身并未针对批量操作进行优化,但可以使用一些技术来高效地执行批量插入。

2.1.1 示例:使用 saveAll() 进行批量插入

使用 Spring Data JPA 进行批量插入的最简单方法是使用 JpaRepository 提供的 saveAll() 方法。

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import java.util.List;

@Service

public class UserService {

@Autowired

private UserRepository userRepository;

public void bulkInsertUsers(List<User> users) {

userRepository.saveAll(users);

}

}saveAll() 方法适用于中小型数据集。然而,对于非常大的数据集,性能可能不够理想,内存消耗也可能成为问题。

2.1.2 saveAll() 的局限性

- 事务开销:每个实体都在事务中单独处理,这对于大数据集来说效率低下。

- 批处理大小:

saveAll()方法不会自动批处理插入,可能导致性能瓶颈。

2.2 使用 Hibernate 的批处理优化

Hibernate 是 Spring Boot 中默认的 JPA 实现,提供了批处理功能,可用于优化批量插入操作。

2.2.1 配置批处理

要启用批处理,请在 application.properties 或 application.yml 文件中配置以下属性:

spring.jpa.properties.hibernate.jdbc.batch_size=50

spring.jpa.properties.hibernate.order_inserts=true

spring.jpa.properties.hibernate.order_updates=true2.2.2 示例:使用 Hibernate 进行批处理插入

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import org.springframework.transaction.annotation.Transactional;

import java.util.List;

@Service

public class UserService {

@Autowired

private UserRepository userRepository;

@Transactional

public void bulkInsertUsers(List<User> users) {

for (int i = 0; i < users.size(); i++) {

userRepository.save(users.get(i));

if (i % 50 == 0) { // Flush and clear the session every 50 inserts

userRepository.flush();

userRepository.clear();

}

}

}

}通过 Hibernate 的批处理,可以显著提高性能,减少执行的 SQL 语句数量,并优化 JDBC 批处理大小。

2.3 使用原生查询进行批量插入

在需要最大程度控制插入操作的场景中,使用原生 SQL 查询是最有效的方法。

2.3.1 示例:使用原生查询进行批量插入

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.jdbc.core.JdbcTemplate;

import org.springframework.stereotype.Service;

@Service

public class UserService {

@Autowired

private JdbcTemplate jdbcTemplate;

public void bulkInsertUsers(List<User> users) {

String sql = "INSERT INTO users (name, email) VALUES (?, ?)";

jdbcTemplate.batchUpdate(sql, users, 100, (ps, user) -> {

ps.setString(1, user.getName());

ps.setString(2, user.getEmail());

});

}

}使用原生查询为批量插入提供了最佳性能,尤其是在处理非常大的数据集时。然而,它需要更多的手动工作来管理 SQL 并确保其与数据库兼容。

2.4 使用 Spring Batch 进行大规模批量插入

Spring Batch 是一个强大的框架,专为企业应用程序中的批处理而设计。它特别适用于大规模的批量插入操作,提供了分块处理、作业管理和重试机制等功能。

2.4.1 示例:使用 Spring Batch 进行批量插入

// Configuration class for Spring Batch Job

@Configuration

public class BatchConfig {

@Autowired

private JobBuilderFactory jobBuilderFactory;

@Autowired

private StepBuilderFactory stepBuilderFactory;

@Autowired

private UserRepository userRepository;

@Bean

public Job bulkInsertJob() {

return jobBuilderFactory.get("bulkInsertJob")

.start(bulkInsertStep())

.build();

}

@Bean

public Step bulkInsertStep() {

return stepBuilderFactory.get("bulkInsertStep")

.<User, User>chunk(100)

.reader(userReader())

.processor(userProcessor())

.writer(userWriter())

.build();

}

@Bean

public ItemReader<User> userReader() {

// Implement your reader

}

@Bean

public ItemProcessor<User, User> userProcessor() {

// Implement your processor

}

@Bean

public ItemWriter<User> userWriter() {

return items -> userRepository.saveAll(items);

}

}Spring Batch 提供了一种强大而灵活的方式来处理大规模的批量插入,使其成为企业级应用程序的理想选择。它还提供了对事务管理、重试机制和作业监控的内置支持。

3. Spring Boot 中批量插入的多个维度

了解批量插入操作的不同维度有助于根据应用程序的具体需求做出明智的决策。

- • 性能考虑:批量插入可以通过减少数据库往返次数显著提高性能。然而,必须适当配置数据库和 ORM(对象关系映射)工具以避免瓶颈。

- • 内存管理:在执行批量插入时,尤其是处理大数据集时,内存管理变得至关重要。使用 Hibernate 中的刷新和清空会话技术或 Spring Batch 中的分块处理技术可以帮助有效管理内存。

- • 错误处理和事务:批量插入通常涉及多条记录,这使得错误处理和事务管理更加复杂。使用 Spring Batch 等框架可以通过提供内置的回滚和重试机制来简化此过程。

- • 数据库特定的优化:不同的数据库提供了各种优化批量插入的技术。例如,PostgreSQL 和 MySQL 支持通过原生 SQL 进行批量插入,并且可以通过调整数据库配置(如缓冲区大小和连接池设置)进一步优化这些操作。

4. 结论

批量插入操作是优化 Spring Boot 应用程序数据库性能的强大工具。通过选择正确的策略——无论是使用 Spring Data JPA、Hibernate 的批处理、原生查询还是 Spring Batch——你都可以高效地处理大数据集,同时保持良好的性能和可扩展性。通过本文提供的示例和演示,你应该能够根据特定需求在 Spring Boot 项目中实现批量插入。

没有回复内容